Η υποστήριξη OpenGL του προγράμματος Asahi Linux στους επεξεργαστές Apple ξεπέρασε επίσημα την υποστήριξη της Apple

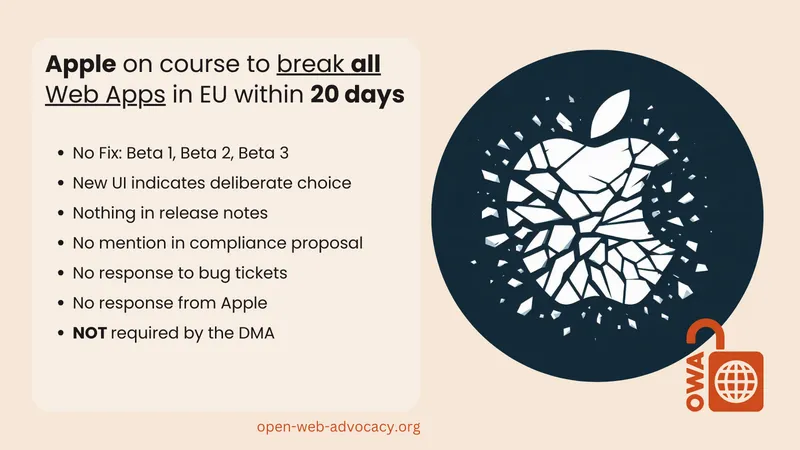

Η ομάδα βελτιώνει σταθερά το συμβατό με τα πρότυπα πρόγραμμα οδήγησης GPU ανοιχτού κώδικα για τα M1 και M2 από τότε που τα κυκλοφόρησε τον Δεκέμβριο του 2022 και σήμερα, η ομάδα πέρασε ένα σημαντικό συμβολικό ορόσημο: Η υποστήριξη του προγράμματος οδήγησης Asahi για τα γραφικά OpenGL και OpenGL ES έχει ξεπεράσει επίσημα αυτό που προσφέρει η Apple στο macOS. Το τελευταίο πρόγραμμα οδήγησης γραφικών της ομάδας συμμορφώνεται πλήρως με την έκδοση 4.6 της OpenGL και την έκδοση 3.2 της OpenGL ES, την πιο πρόσφατη έκδοση και των δύο API. Η υποστήριξη της Apple στο macOS ολοκληρώνεται στην OpenGL 4.1, η οποία ανακοινώθηκε τον Ιούλιο του 2010.

Η προγραμματιστής Alyssa Rosenzweig έγραψε μια λεπτομερή ανάρτηση στο blog που ανακοίνωσε το νέο πρόγραμμα οδήγησης, το οποίο έπρεπε να περάσει "πάνω από 100.000 δοκιμές" για να θεωρηθεί επίσημα συμβατό. Η ομάδα πέτυχε αυτό το ορόσημο παρά το γεγονός ότι οι GPU της Apple δεν υποστηρίζουν ορισμένα χαρακτηριστικά που θα έκαναν την εφαρμογή αυτών των API πιο απλή.

"Δυστυχώς, η M1 δεν αντιστοιχίζεται καλά σε κανένα πρότυπο γραφικών νεότερο από το OpenGL ES 3.1", γράφει ο Rosenzweig. "Ενώ το Vulkan καθιστά ορισμένα από αυτά τα χαρακτηριστικά προαιρετικά, τα χαρακτηριστικά που λείπουν απαιτούνται για την επικάλυψη των DirectX και OpenGL. Καμία υπάρχουσα λύση στο M1 δεν ξεπερνά το σύνολο χαρακτηριστικών της OpenGL 4.1... Χωρίς υποστήριξη υλικού, τα νέα χαρακτηριστικά χρειάζονται νέα κόλπα. Τα Geometry shaders, το tessellation,και το transform feedback γίνονται shaders υπολογισμού, κ.ο.κ.

Τώρα που το πρόγραμμα οδήγησης GPU της Asahi υποστηρίζει τα τελευταία πρότυπα OpenGL και OpenGL ES -που κυκλοφόρησαν το 2017 και το 2015, αντίστοιχα- το έργο στρέφεται στην υποστήριξη του API Vulkan με χαμηλό κόστος στο υλικό της Apple. Η υποστήριξη Vulkan στο macOS περιορίζεται σε στρώματα μετάφρασης όπως το MoltenVK, το οποίο μεταφράζει τις κλήσεις API Vulkan σε κλήσεις Metal που μπορούν να κατανοήσουν το υλικό και το λειτουργικό σύστημα.

Η υποστήριξη OpenGL της Apple έχει κολλήσει στο επίπεδο 4.1 από τότε που κυκλοφόρησε το macOS 10.9 Mavericks το 2013. Έκτοτε, η εταιρεία έχει στρέψει την προσοχή της στο ιδιόκτητο Metal graphics API, το οποίο, όπως το DirectX 12 και το Vulkan, είναι ένα API "χαμηλού κόστους" που προορίζεται να μειώσει το κόστος απόδοσης που συνδέεται μερικές φορές με παλαιότερα API όπως το OpenGL. Όμως, παρά το γεγονός ότι η Apple δήλωσε ότι η OpenGL έχει επίσημα καταργηθεί το 2018, άφησε έκτοτε την υπάρχουσα υλοποίηση της OpenGL μόνη της, χωρίς ποτέ να την ενημερώσει, αλλά και διατηρώντας την υποστήριξή της ακόμη και κατά τη μετάβαση από τους επεξεργαστές της Intel στις δικές της CPU και GPU.

Η ανάρτηση του Rosenzweig στο blog δεν έδωσε συγκεκριμένες ενημερώσεις σχετικά με το Vulkan, εκτός από το να πει ότι η ομάδα ήταν "σε καλό δρόμο" για την υποστήριξή του. Εκτός από την υποστήριξη εγγενών εφαρμογών Linux, η υποστήριξη περισσότερων APIs γραφικών στο Asahi θα επιτρέψει στο λειτουργικό σύστημα να εκμεταλλευτεί καλύτερα λογισμικό όπως το Proton της Valve, το οποίο έχει ήδη μερικά παιχνίδια γραμμένα για υπολογιστές Windows με βάση x86 που τρέχουν σε υλικό της Apple με βάση το Arm.

Αν και υπάρχουν ακόμα πράγματα που δεν λειτουργούν, το Fedora Asahi Remix είναι εκπληκτικά προσεγμένο και υποστηρίζει πολλά από τα υλικά που είναι διαθέσιμα στα περισσότερα Mac M1 και M2 -συμπεριλαμβανομένων της κάμερας, των ηχείων, του Wi-Fi και του Bluetooth και της επιτάχυνσης γραφικών. Άλλα χαρακτηριστικά, όπως το Thunderbolt, η εκτέλεση οθονών μέσω USB-C, το ενσωματωμένο μικρόφωνο του συστήματος και οι αισθητήρες δακτυλικών αποτυπωμάτων Touch ID, παραμένουν μη λειτουργικά. Η πιο πρόσφατη ανάρτηση στο blog της Asahi για την ενημέρωση, που δημοσιεύτηκε στα μέσα Ιανουαρίου, υπογράμμισε την υποστήριξη HDMI, την υποστήριξη για ιστότοπους που προστατεύονται από DRM μέσω του ιδιόκτητου πακέτου Widevine της Google, την υποστήριξη Touchbar για τα Apple Silicon Macs που χρησιμοποιούν ένα τέτοιο, και πολλά άλλα.

Όσον αφορά το νεότερο κύμα των M3 Macs, ο προγραμματιστής της Asahi Hector Martin δήλωσε τον Οκτώβριο του 2023 ότι η βασική υποστήριξη για τα νεότερα τσιπ θα χρειαστεί "τουλάχιστον έξι μήνες". Μεταξύ άλλων, η ομάδα θα χρειαστεί χρόνο για να υποστηρίξει την GPU M3 στους οδηγούς της- η ομάδα βασίζεται επίσης κυρίως σε μοντέλα Mac mini για την ανάπτυξη, και ο M3 Mac mini δεν υπάρχει ακόμα.

754

.jpg.67a59eb5d6f6d772891f8c4501eecaa8.jpg)

.thumb.jpg.14a3df6f5853e0ce92219404fd5d940d.jpg)