Ο ανθρώπινος εγκέφαλος είναι ένας αργός αλλά εξαιρετικά αποτελεσματικός υπερυπολογιστής

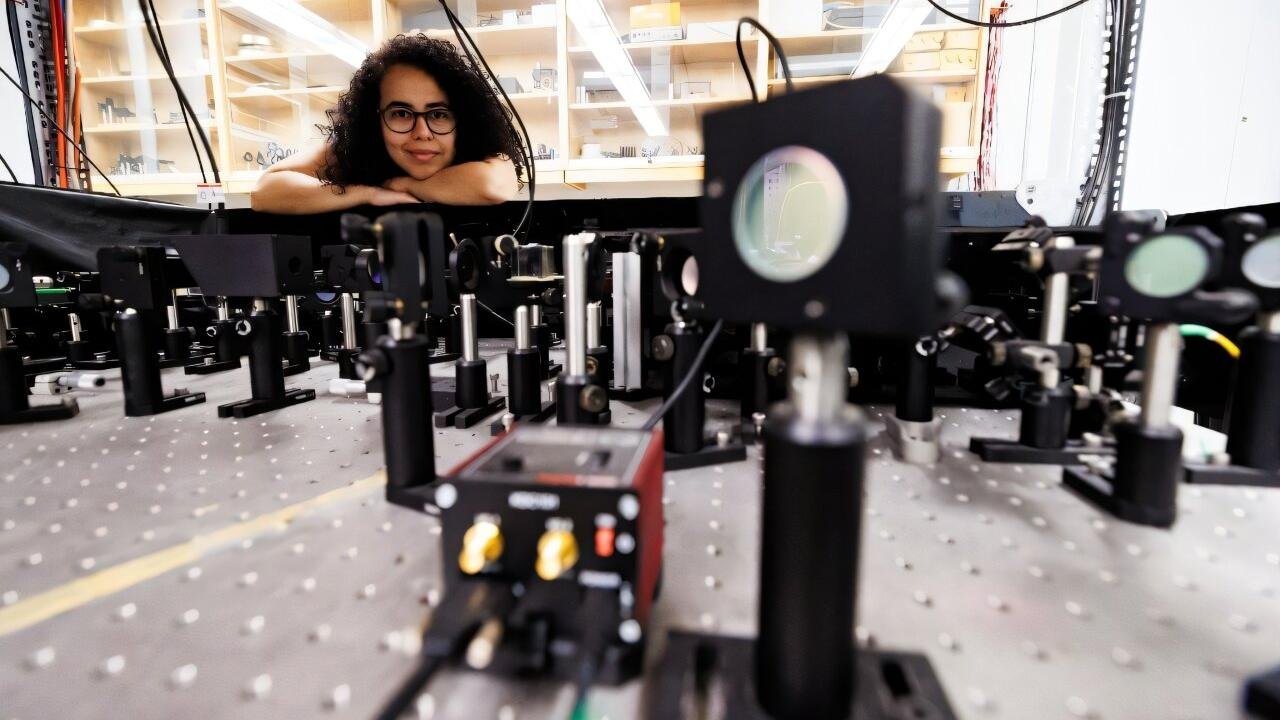

Η έρευνα των Jieyu Zheng και Markus Meister, με τίτλο The Unbearable Slowness of Being, υποδεικνύει ότι αυτός ο περιορισμός δεν είναι τυχαίος, αλλά αποτέλεσμα εξελικτικής στρατηγικής. Ο εγκέφαλος έχει σχεδιαστεί για επιβίωση, φιλτράροντας τον καταιγισμό των πληροφοριών ώστε να επικεντρωθεί σε ό,τι έχει πραγματικά σημασία. Αυτό του επιτρέπει να ενεργεί γρήγορα και αποτελεσματικά, χωρίς να καταρρέει από τον όγκο των δεδομένων.

Τεχνολογία και ανθρώπινοι περιορισμοί

Η πρόοδος τεχνολογιών, όπως η Neuralink του Elon Musk, υπόσχεται τη δημιουργία διασυνδέσεων μεταξύ εγκεφάλου και μηχανών. Ωστόσο, η έρευνα δείχνει ότι ακόμα και με αυτές τις καινοτομίες, ο φυσικός ρυθμός επεξεργασίας του εγκεφάλου παραμένει στα 10 bits ανά δευτερόλεπτο. Αυτό οφείλεται σε βιολογικούς και όχι τεχνολογικούς περιορισμούς.

Αυτό το «bottleneck» έχει σοβαρές συνέπειες σε τομείς όπως οι νευροπροσθετικές συσκευές. Για παράδειγμα, οι συσκευές αποκατάστασης όρασης που προσπαθούν να μεταδώσουν ακατέργαστο βίντεο στον εγκέφαλο υπερφορτώνουν την ικανότητά του να επεξεργαστεί τα δεδομένα. Μια πιο ρεαλιστική προσέγγιση θα ήταν η μετατροπή των οπτικών πληροφοριών σε σύντομα, χρήσιμα μηνύματα, όπως η αναγνώριση αντικειμένων ή κινδύνων.

Η σοφία της «αργοπορίας»

Παρότι η αργή ταχύτητα του εγκεφάλου μπορεί να φαίνεται ως μειονέκτημα στον σημερινό κόσμο, ήταν αρκετή για την επιβίωση των ανθρώπων σε όλη την ιστορία. Η εξέλιξη έθεσε ως προτεραιότητα την ενεργειακή αποδοτικότητα αντί για την ταχύτητα, επιτρέποντας στον εγκέφαλο να επικεντρώνεται σε κρίσιμες εργασίες χωρίς να σπαταλά ενέργεια.

Η έρευνα των Zheng και Meister θέτει ένα ενδιαφέρον ερώτημα: γιατί ένας εγκέφαλος με τέτοια πολυπλοκότητα λειτουργεί τόσο αργά; Η απάντηση σε αυτό το παράδοξο μπορεί να οδηγήσει σε σημαντικές ανακαλύψεις στη νευροεπιστήμη και την τεχνητή νοημοσύνη. Για την ώρα, είναι σαφές ότι, αν και αργός, ο εγκέφαλος είναι ακριβώς τόσο γρήγορος όσο χρειάζεται.

444

.thumb.jpg.14a3df6f5853e0ce92219404fd5d940d.jpg)